Linux块层多队列中如何引入内核

本篇内容主要讲解“Linux块层多队列中如何引入内核”,感兴趣的朋友不妨来看看。本文介绍的方法操作简单快捷,实用性强。下面就让小编来带大家学习“Linux块层多队列中如何引入内核”吧!

在麒麟等地区,都构建了全面的区域性战略布局,加强发展的系统性、市场前瞻性、产品创新能力,以专注、极致的服务理念,为客户提供成都做网站、网站制作 网站设计制作按需设计网站,公司网站建设,企业网站建设,品牌网站设计,全网整合营销推广,外贸营销网站建设,麒麟网站建设费用合理。

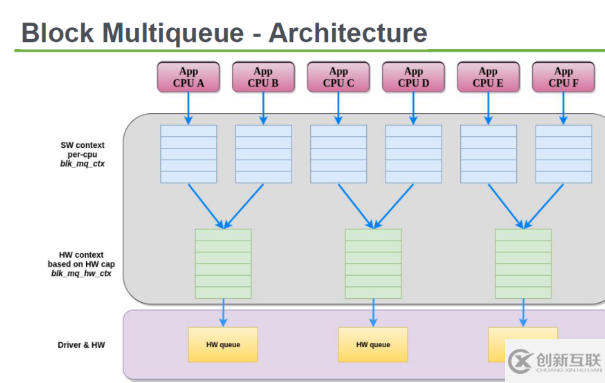

首先过目一下多队列架构:

以读IO为例,单队列和多队列相同的执行路径:

read_pages() { ... blk_start_plug() /* 进程准备蓄流 */ mapping->a_ops->readpages() /* 蓄流 */ blk_finish_plug() /* 进程开始泄流 */ ... } io_schedule() 进程蓄流之后等待io完成 (在blk_mq_make_request()函数中request的数目大于或者等于16 request_count >= BLK_MAX_REQUEST_COUNT 不需要调用io_schedule(),直接泄流到块设备驱动)mapping->a_ops->readpages() 会一直调用q->make_request_fn()

generic_make_request() q->make_request_fn() 调用blk_queue_bio()或者 多队列blk_queue_make_request() __elv_add_request()

为什么引入多队列:多队列相对与单队列来说,每个cpu上都有一个软队列(使用blk_mq_ctx结构表示)避免插入request的时候使用spinlock锁,而且如今的高速存储设备,比如支持nvme的ssd(小弟刚买了一块,速度确实快),访问延迟非常小,而且本身硬件就支持多队列,(引入的多队列使用每个硬件队列

单队列插入request时会使用request_queue上的全局spinlock锁

blk_queue_bio() { ... spin_lock_irq(q->queue_lock); elv_merge() spin_lock_irq(q->queue_lock); ... }单队列泄流到块设备驱动时也是使用request_queue上的全局spinlock锁:

struct request_queue *blk_alloc_queue_node() INIT_DELAYED_WORK(&q->delay_work, blk_delay_work); blk_delay_work() __blk_run_queue() q->request_fn(q);

__blk_run_queue()函数必须在队列锁中,也就是spin_lock_irq(q->queue_lock);

281 * __blk_run_queue - run a single device queue 282 * @q: The queue to run 283 * 284 * Description: 285 * See @blk_run_queue. This variant must be called with the queue lock 286 * held and interrupts disabled. 287 */ 288 void __blk_run_queue(struct request_queue *q) 289 { 290 if (unlikely(blk_queue_stopped(q))) 291 return; 292 293 __blk_run_queue_uncond(q); 294 }多队列插入request时没有使用spinlock锁:

blk_mq_insert_requests() __blk_mq_insert_request() struct blk_mq_ctx *ctx = rq->mq_ctx; (每cpu上的blk_mq_ctx) list_add_tail(&rq->queuelist, &ctx->rq_list)

多队列泄流到块设备驱动也没有使用spinlock锁:

static int blk_mq_init_hw_queues() INIT_DELAYED_WORK(&hctx->delayed_work, blk_mq_work_fn); 708 static void blk_mq_work_fn(struct work_struct *work) 709 { 710 struct blk_mq_hw_ctx *hctx; 711 712 hctx = container_of(work, struct blk_mq_hw_ctx, delayed_work.work); 713 __blk_mq_run_hw_queue(hctx); 714 } __blk_mq_run_hw_queue() 没有spinlock锁 q->mq_ops->queue_rq(hctx, rq); 执行多队列上的->queue_rq()回调函数从下图可以看出系统使用多队列之后的性能提升:

(我自己没测试过性能,凭客观想象应该与下列图相符:) )

到此,相信大家对“Linux块层多队列中如何引入内核”有了更深的了解,不妨来实际操作一番吧!这里是创新互联网站,更多相关内容可以进入相关频道进行查询,关注我们,继续学习!

网页名称:Linux块层多队列中如何引入内核

分享网址:https://www.cdcxhl.com/article26/ghopcg.html

成都网站建设公司_创新互联,为您提供电子商务、外贸建站、服务器托管、企业建站、企业网站制作、网站排名

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 企业网站制作之后如何让网站带来客户 2021-10-28

- 企业网站制作设计注意的问题! 2016-11-08

- 企业网站制作的流程步骤具体包括哪些? 2023-03-09

- 企业网站制作推广中的看价格失误 2013-11-22

- 从扁平化谈企业网站制作 2021-08-28

- 企业网站制作要注意色彩的几个方面 2021-12-14

- 企业网站制作如何设计的更大气! 2016-09-06

- 企业网站制作需要注意几个方面 2022-05-15

- 企业网站制作和设计的核心是什么 2021-11-21

- 如何制作企业网站才可以实现目标呢? 2014-01-26

- 企业网站制作方案要怎么写 2022-07-07

- 企业网站制作如何赢得更好的营销效果? 2022-10-15