backpropagation-创新互联

http://deeplearning.stanford.edu/wiki/index.php/%E5%8F%8D%E5%90%91%E4%BC%A0%E5%AF%BC%E7%AE%97%E6%B3%95

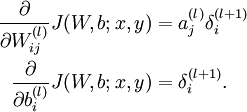

成都创新互联公司是一家专业提供米脂企业网站建设,专注与成都网站建设、成都网站制作、H5场景定制、小程序制作等业务。10年已为米脂众多企业、政府机构等服务。创新互联专业网站制作公司优惠进行中。 反向传播算法的思路如下:给定一个样例  ,我们首先进行“前向传导”运算,计算出网络中所有的激活值,包括

,我们首先进行“前向传导”运算,计算出网络中所有的激活值,包括  的输出值。之后,针对第

的输出值。之后,针对第  层的每一个节点

层的每一个节点  ,我们计算出其“残差”

,我们计算出其“残差”  ,该残差表明了该节点对最终输出值的残差产生了多少影响。对于最终的输出节点,我们可以直接算出网络产生的激活值与实际值之间的差距,我们将这个差距定义为

,该残差表明了该节点对最终输出值的残差产生了多少影响。对于最终的输出节点,我们可以直接算出网络产生的激活值与实际值之间的差距,我们将这个差距定义为  (第

(第  层表示输出层)。对于隐藏单元我们如何处理呢?我们将基于节点(译者注:第

层表示输出层)。对于隐藏单元我们如何处理呢?我们将基于节点(译者注:第  层节点)残差的加权平均值计算

层节点)残差的加权平均值计算  ,这些节点以

,这些节点以  作为输入。

作为输入。

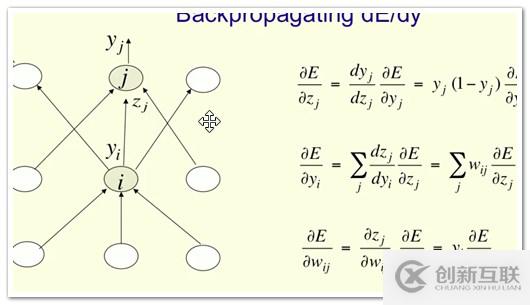

$ delta 3=frac{d Error}{d x_3}=frac{d 1/2*(t-y_3)^2}{d x} =-(t-y_3)*y_{3}^{'} $

$ delta 2=frac{d Error}{d x_2}=frac{d E}{d x_3} frac{d x_3}{d y_2} frac{d y_2}{d x_2}= delta 3*w2*y_{2}^{'} $

计算我们需要的偏导数,计算方法如下:

($a^(l)_j$是activation, j是前一层,i是后一层)

是sum上面一层,而forward是sum下面一层。

若不是sigmoid,则$Delta wi=exi$

还有一个问题,当f(x)接近1或接近0时,gradient非常小,几乎为0,这时没法更新weight,错误无法修正

tj只有当是结果是才为1,其余时候为0.

网站题目:backpropagation-创新互联

转载来源:https://www.cdcxhl.com/article24/cceije.html

成都网站建设公司_创新互联,为您提供商城网站、建站公司、电子商务、企业建站、网站内链、网页设计公司

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 服务器托管一定要避免的9种机房现状 2021-03-12

- 服务器托管如何选择好的机房? 2022-10-07

- 云服务器租用与服务器托管相比有什么优势 2021-02-21

- 什么是高防服务器托管? 2022-10-03

- 企业要选服务器托管的原因是什么 2022-10-03

- 什么是服务器?服务器托管与租用有什么不同? 2022-10-03

- 艾克赛乐服务器托管怎么样? 2021-03-10

- 服务器托管与虚拟主机托管有什么区别 2022-06-20

- 关于网站服务器托管需要注意问题 2016-11-07

- 服务器托管机房选择需要注意的几个问题 2022-10-09

- 什么是服务器托管?服务器托管有什么好处? 2023-01-07

- 企业服务器托管有什么技巧?企业服务器托管该注意哪些问题? 2022-10-02