scrapy导出文件中文乱码问题-创新互联

背景:

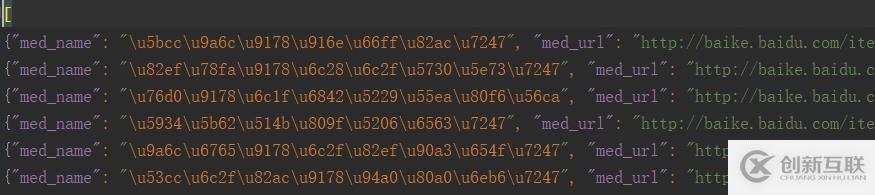

使用scrapy crawl spidername -o filename.json命令执行爬虫,并将item写入文件,发现中文乱码,比如这样子:

解决方法

第一种方法:

使用scrapy命令导出时指定编码格式

scrapy crawl baidu -o baidu_med.json -s FEED_EXPORT_ENCODING=utf-8第二种方法:

借助Pipeline将item写入到文件

1.修改pipelines.py,添加:

import json

import codecs

class YiyaoPipeline(object):

def __init__(self):

self.file = codecs.open('item.json', 'wb', encoding='utf-8')

def process_item(self, item, spider):

line = json.dumps(dict(item), ensure_ascii=False) + '\n'

self.file.write(line)

return item2.修改settings.py,激活pipeline:

ITEM_PIPELINES = {

'yiyao.pipelines.YiyaoPipeline': 300,

}注意:settings.py默认有ITEM_PIPELINES配置,只是注销掉了。

3.使用scrapy命令导出时,直接执行:

scrapy crawl baidu

分享题目:scrapy导出文件中文乱码问题-创新互联

标题网址:https://www.cdcxhl.com/article48/djdoep.html

成都网站建设公司_创新互联,为您提供定制开发、微信公众号、软件开发、标签优化、网站维护、虚拟主机

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 企业网站制作在验收的时候应该注意哪些问题呢? 2022-08-07

- 成都企业网站制作价格 2022-07-15

- 企业网站制作设计攻略(必看) 2020-11-25

- 成都中小企业网站制作:有些网站SEO没有很好的优化 2022-12-04

- 企业网站制作改版注意事项有哪些? 2021-11-18

- 企业网站制作相关性与原创性要保持 2021-11-14

- 北京企业网站制作如何选择服务器 2020-12-19

- 为什么部门企业网站制作选择动态网页 2021-11-13

- 石家庄企业网站制作:如何设计一个创意新颖的企业站呢? 2021-10-14

- 成都企业网站制作公司讲解企业网站的安全措施 2023-03-27

- 企业网站制作中如何做到标题的规范化? 2021-07-19

- 企业网站制作费用多少钱?需要收取哪些部分的费用呢? 2022-11-11