Hadoop文件合并——HadoopInAction上的一个示例

上一篇文章已经详细的说明了如何在Eclipse下面远程连接Hadoop集群,进行Hadoop程序开发。这里说明一个Hadoop In Action书上的一个示例,可能是由于Hadoop版本更新的问题,导致树上的一些个示例程序没有办法正常执行。

10年积累的成都网站制作、网站建设经验,可以快速应对客户对网站的新想法和需求。提供各种问题对应的解决方案。让选择我们的客户得到更好、更有力的网络服务。我虽然不认识你,你也不认识我。但先建设网站后付款的网站建设流程,更有芦溪免费网站建设让你可以放心的选择与我们合作。

整个代码的工作就是把本地目录下个若干个小文件,合并成一个较大的文件,写入到HDFS中。话不多说,代码如下:

补充说明:后来发现,书上的源代码是没有问题的,只不过是书上的源代码要打成jar包,放在集群的机器上去运行,如果在Eclipse下面调试运行的话,就会出现问题。出现问题的原因如下

//读取本地文件系统,如果要想正确运行,必须要打成jar包,在hadoop集群的机器上面运行 FileSystem hdfs = FileSystem.get(conf); FileSystem local = FileSystem.getLocal(conf); //通过URI可以远程读取HDFS,所以Eclipse下面调试要使用这种写法,打成jar包这种形式也是可以的 FileSystem hdfs = FileSystem.get(URI.create(serverPath), conf); FileSystem local = FileSystem.getLocal(conf);

package com.hadoop.examples;

import java.io.IOException;

import java.net.URI;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

/**

* @Package

* @ClassName: PutMerge

* @Description: 读取本地目录下的文件,写入到HDFS,在写入的过程中,

* 把这三个文件合成一个文件

* @author lxy

* @date 2015年3月25日 上午9:59:38

* @version V1.0

*/

public class PutMerge {

public static void main(String[] args) throws IOException {

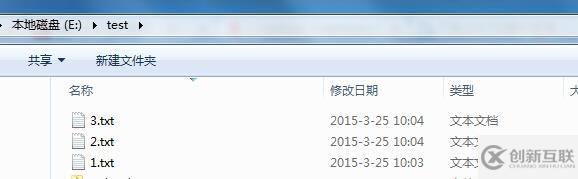

// 输入目录,目录下有三个txt,文章最后面会儿给出文件内容

String localPathStr = "E:\\test";

// 输出目录,HDFS路径,文章最后面会给出合并之后的文件内容

String serverPath =

"hdfs://192.168.3.57:8020/user/lxy/mergeresult/merge.txt";

//输入目录,是一个本地目录

Path inputDir = new Path(localPathStr);

//输出目录,是一个HDFS路径

Path hdfsFile = new Path(serverPath);

Configuration conf = new Configuration();

/**

* Hadoop in Action的原代码如下

* FileSystem hdfs = FileSystem.get(conf);

* 但是这样的话,使用Eclipse调试时,执行下面的语句是就会报异常,因为它是读取本地

* 文件系统

* FSDataOutputStream out = hdfs.create(hdfsFile);

*/

// 根据上面的serverPath,获取到的是一个org.apache.hadoop.hdfs.DistributedFileSystem对象

FileSystem hdfs = FileSystem.get(URI.create(serverPath), conf);

FileSystem local = FileSystem.getLocal(conf);

try {

//获取输入目录下的文件以及文件夹列表

FileStatus[] inputFiles = local.listStatus(inputDir);

//在hdfs上创建一个文件

FSDataOutputStream out = hdfs.create(hdfsFile);

for (int i = 0; i < inputFiles.length; i++) {

System.out.println(inputFiles[i].getPath().getName());

//打开本地输入流

FSDataInputStream in = local.open(inputFiles[i].getPath());

byte buffer[] = new byte[256];

int bytesRead = 0;

while ((bytesRead = in.read(buffer)) > 0) {

//往hdfs上的文件写数据

out.write(buffer, 0, bytesRead);

}

//释放资源

in.close();

}

//释放资源

out.close();

}

catch (IOException e) {

e.printStackTrace();

}

}

}我的测试目录下有三个txt文件

1.txt

1 hello Hadoop 2 hello Hadoop 3 hello Hadoop 4 hello Hadoop 5 hello Hadoop 6 hello Hadoop 7 hello Hadoop

2.txt

8 hello Hadoop 9 hello Hadoop 10 hello Hadoop 11 hello Hadoop 12 hello Hadoop 13 hello Hadoop 14 hello Hadoop

3.txt

15 hello Hadoop 16 hello Hadoop 17 hello Hadoop 18 hello Hadoop 19 hello Hadoop 20 hello Hadoop 21 hello Hadoop

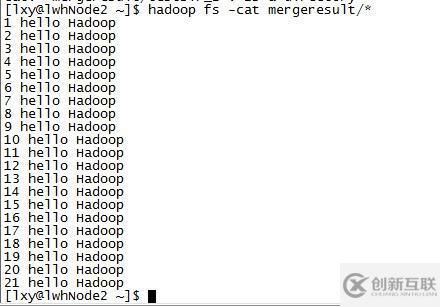

合并之后的文件如下所示:

标题名称:Hadoop文件合并——HadoopInAction上的一个示例

文章路径:https://www.cdcxhl.com/article40/gpiiho.html

成都网站建设公司_创新互联,为您提供小程序开发、ChatGPT、营销型网站建设、全网营销推广、网站排名、搜索引擎优化

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 自适应网站和普通的网站有什么不同 2016-11-11

- 响应式网站和自适应网站会有什么样的区别? 2016-08-24

- 【成都网站建设】自适应网站和响应式网站之间的区别? 2013-07-27

- 响应式网站建设与自适应网站建设的区别 2016-11-12

- 自适应网站建设应该注意哪些方面呢? 2017-02-19

- H5自适应网站建设要注意哪些方面 2020-12-04

- 自适应网站有和特点和优势呢? 2016-11-12

- 自适应网站基本建设的常见问题有哪些? 2022-11-11

- 自适应网站在建时必须要注意的几大问题 2023-02-06

- 浅谈自适应网站建设 2021-05-21

- 网页设计制作:营销型网站建设或是自适应网站建设的区别 2022-05-05

- 自适应网站模版建设的常见问题 2023-01-10