hadoop分布式集群的搭建过程-创新互联

这篇文章主要讲解了“hadoop分布式集群的搭建过程”,文中的讲解内容简单清晰,易于学习与理解,下面请大家跟着小编的思路慢慢深入,一起来研究和学习“hadoop分布式集群的搭建过程”吧!

hadoop分布式集群搭建:

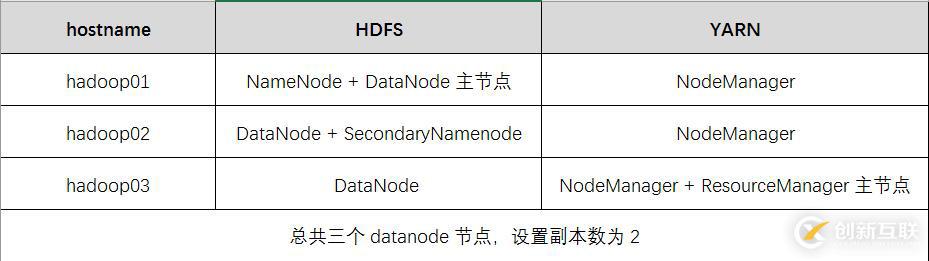

1. 集群规划:

2.具体步骤:

(1)上传安装包,并解压到相关目录:

[hadoop@hadoop01 home]$ put c:/hadoop-2.6.5-centos-6.7.tar.gz

[hadoop@hadoop01 home]$tar -zxvf hadoop-2.6.5-centos-6.7.tar.gz -C /home/hadoop/apps

(2)修改配置文件:

[hadoop@hadoop01 home]$ cd /home/hadoop/apps/hadoop-2.6.5/hadoop/etc

这里需要修改6个配置文件:

hadoop-env.sh:

加入:export JAVA_HOME=/usr/java/jdk1.8.0_73

core-site.xml:

<property> <name>fs.defaultFS</name> <value>hdfs://hadoop01:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/home/hadoop/hadoopdata</value> </property>

hdfs-site.xml:

<property> <name>dfs.namenode.name.dir</name> <value>/home/hadoop/hadoopdata/name</value> <description>为了保证元数据的安全一般配置多个不同目录</description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hadoop/hadoopdata/data</value> <description>datanode 的数据存储目录</description> </property> <property> <name>dfs.replication</name> <value>2</value> <description>HDFS 的数据块的副本存储个数</description> </property> <property> <name>dfs.secondary.http.address</name> <value>hadoop02:50090</value> <description>secondarynamenode 运行节点的信息,和 namenode 不同节点</description> </property>

mapred-site.xml:

<property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

yarn-site.xml:

<property> <name>yarn.resourcemanager.hostname</name> <value>hadoop03</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> <description>YARN 集群为 MapReduce 程序提供的 shuffle 服务</description> </property>

slaves:

hadoop01 hadoop02 hadoop03

(3)分发安装包到各个节点,Hadoop 集群的每个节点都需要安装 Hadoop 安装包:

[hadoop@hadoop01 etc]$scp -r hadoop-2.6.5 hadoop02:$PWD

[hadoop@hadoop01 etc]$scp -r hadoop-2.6.5 hadoop03:$PWD

(4)配置hadoop的环境变量

[hadoop@hadoop01 etc]$sudo vim /etc/profile:

加入:

export HADOOP_HOME=/home/hadoop/apps/hadoop-2.6.5/

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

[hadoop@hadoop01 etc]$source /etc/profile

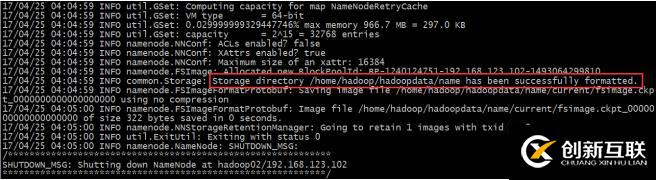

(5)在 HDFS 主节点上执行命令进行初始化 namenode

[hadoop@hadoop01 etc]$hadoop namenode -format

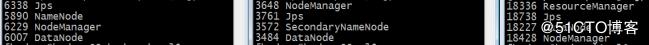

(6)在 HDFS 上的主节点启动 HDFS

[hadoop@hadoop01 etc]$start-dfs.sh

(7)在 HDFS 上的主节点启动 YARN

[hadoop@hadoop01 etc]$sbin/start-yarn.sh

补充:

hdfs的web界面是: http://hadoop01:50070

yarn的web界面是: http://hadoop03:8088

查看集群的状态:hdfs dfsadmin -report

1、启动 namenode 或者 datenode

sbin/hadoop-daemon.sh start datanode

sbin/hadoop-daemon.sh start namenode

sbin/hadoop-daemon.sh start secondarynamenode

2、启动 yarn nodemanager

sbin/yarn-daemon.sh start nodemanager

sbin/yarn-daemon.sh start resourcemanager

感谢各位的阅读,以上就是“hadoop分布式集群的搭建过程”的内容了,经过本文的学习后,相信大家对hadoop分布式集群的搭建过程这一问题有了更深刻的体会,具体使用情况还需要大家实践验证。这里是创新互联,小编将为大家推送更多相关知识点的文章,欢迎关注!

另外有需要云服务器可以了解下创新互联scvps.cn,海内外云服务器15元起步,三天无理由+7*72小时售后在线,公司持有idc许可证,提供“云服务器、裸金属服务器、高防服务器、香港服务器、美国服务器、虚拟主机、免备案服务器”等云主机租用服务以及企业上云的综合解决方案,具有“安全稳定、简单易用、服务可用性高、性价比高”等特点与优势,专为企业上云打造定制,能够满足用户丰富、多元化的应用场景需求。

网站名称:hadoop分布式集群的搭建过程-创新互联

本文链接:https://www.cdcxhl.com/article14/dddede.html

成都网站建设公司_创新互联,为您提供全网营销推广、用户体验、品牌网站设计、网站设计、面包屑导航、微信公众号

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 莱芜网站优化整站优化如何作用于虚拟主机? 2023-01-03

- 企业选择虚拟主机要考虑什么?有什么要注意的? 2021-02-05

- 网站建设怎样选择虚拟主机? 2016-01-15

- 虚拟主机的类型应该怎么选? 2016-11-06

- 网站建设选择虚拟主机时有哪些技巧 2021-02-23

- 免费云虚拟主机申请哪些要注意? 2022-10-02

- 服务器之家浅谈虚拟主机与云服务器的区别在哪里? 2022-10-11

- 网站建设的虚拟主机网站空间容量是什么? 2022-05-22

- 虚拟主机使用的常见问题整理 2020-04-19

- 网站用虚拟主机购买问题 2019-01-11

- 网站制作好后有一个概念性的策略我们必须要知道 2022-06-03

- 网站访问速度慢?虚拟主机建站需要注意哪几点 2016-10-12