Python3网络爬虫实战-13、部署相关库ScrapydClient、ScrapydAPI

ScrapydClient的安装

在将 Scrapy 代码部署到远程 Scrapyd 的时候,其第一步就是要将代码打包为 Egg 文件,其次需要将 Egg 文件上传到远程主机,这个过程如果我们用程序来实现是完全可以的,但是我们并不需要做这些工作,因为 ScrapydClient 已经为我们实现了这些功能。

下面我们就来过一下 ScrapydClient 的安装过程。

创新互联是一家专业提供内丘企业网站建设,专注与网站制作、成都网站设计、HTML5建站、小程序制作等业务。10年已为内丘众多企业、政府机构等服务。创新互联专业网络公司优惠进行中。

1. 相关链接

- GitHub:https://github.com/scrapy/scr...

- PyPi:https://pypi.python.org/pypi/...

- 使用说明:https://github.com/scrapy/scr...

2. Pip安装

推荐使用 Pip 安装,命令如下:

pip3 install scrapyd-client3. 验证安装

安装成功后会有一个可用命令,叫做 scrapyd-deploy,即部署命令。

我们可以输入如下测试命令测试 ScrapydClient 是否安装成功:

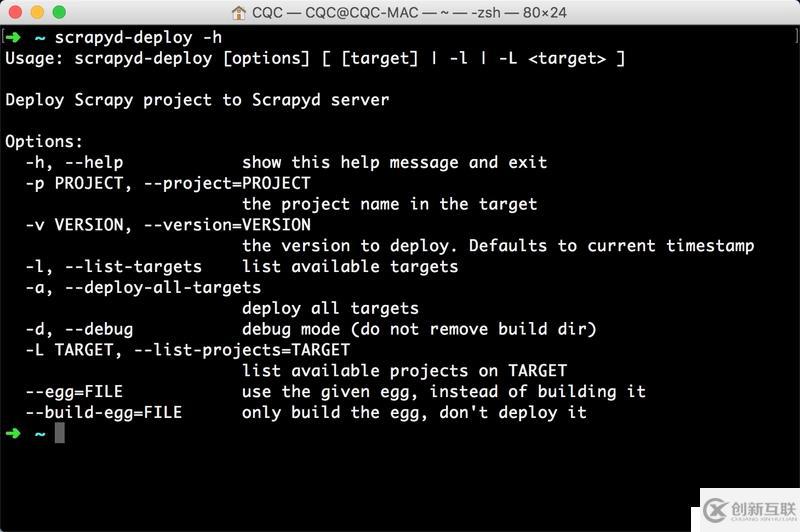

scrapyd-deploy -h

如果出现如图 1-87 类似输出则证明 ScrapydClient 已经成功安装:

图 1-87 运行结果

在后文我们会详细了解它的用法。

ScrapydAPI的安装

安装好了 Scrapyd 之后,我们可以直接请求它提供的 API 即可获取当前主机的 Scrapy 任务运行状况。

如某台主机的 IP 为 192.168.1.1,则可以直接运行如下命令获取当前主机的所有 Scrapy 项目:

curl http://localhost:6800/listprojects.json

Python资源分享qun 784758214 ,内有安装包,PDF,学习视频,这里是Python学习者的聚集地,零基础,进阶,都欢迎运行结果:

{"status": "ok", "projects": ["myproject", "otherproject"]}返回结果是 Json 字符串,通过解析这个字符串我们便可以得到当前主机所有项目。

但是用这种方式来获取任务状态还是有点繁琐,所以 ScrapydAPI 就为它做了一层封装,下面我们来看下它的安装方式。

1. 相关链接

- GitHub:https://pypi.python.org/pypi/...

- PyPi:https://pypi.python.org/pypi/...

- 官方文档:http://python-scrapyd-api.rea...

2. Pip安装

推荐使用 Pip 安装,命令如下:

pip install python-scrapyd-api3. 验证安装

安装完成之后便可以使用 Python 来获取主机状态了,所以如上的操作便可以用 Python 代码实现:

from scrapyd_api import ScrapydAPI

scrapyd = ScrapydAPI('http://localhost:6800')

print(scrapyd.list_projects())运行结果:

["myproject", "otherproject"]

Python资源分享qun 784758214 ,内有安装包,PDF,学习视频,这里是Python学习者的聚集地,零基础,进阶,都欢迎这样我们便可以用 Python 直接来获取各个主机上 Scrapy 任务的运行状态了。

网站题目:Python3网络爬虫实战-13、部署相关库ScrapydClient、ScrapydAPI

文章转载:https://www.cdcxhl.com/article12/ghcigc.html

成都网站建设公司_创新互联,为您提供网站设计公司、网页设计公司、网站建设、电子商务、企业建站、标签优化

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 怎样找到一家靠谱的大连APP定制开发公司? 2023-02-23

- 成都专业网站建设定制开发公司 2016-12-30

- 企业网站搭建选定制开发的好处有哪些? 2020-12-31

- 系统定制开发是什么呢? 2016-08-08

- 为何OA办公系统定制开发的好?OA定制开发需要多少钱? 2022-06-27

- 深圳网站制作:电子商务网站需定制开发? 2022-06-27

- 成都小程序定制开发要怎么做好,优势有哪些? 2022-08-24

- APP定制开发的流程 2022-11-11

- 商城小程序开发选择模板开发还是定制开发? 2022-11-28

- 为什么好的企业网站需要定制开发 2016-09-07

- 北京网站定制开发流程 2020-12-19

- 微信小程序定制开发需要注意的事项 2023-03-07