【Druid】Druid读取Kafka数据的简单配置过程-创新互联

Druid的单机版安装参考:https://blog.51cto.com/10120275/2429912

Druid实时接入Kafka的过程

下载、安装、启动kafka过程:

wget http://mirrors.tuna.tsinghua.edu.cn/apache/kafka/2.2.1/kafka_2.11-2.2.1.tgz

tar -zxvf kafka_2.11-2.2.1.tgz

ln -s kafka_2.11-2.2.1 kafka

$KAFKA_HOME/kafka-server-start.sh ~/kafka/config/server.properties 1>/dev/null 2>&1 &创建topic : wikipedia./bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic wikipedia

解压wikiticker-2015-09-12-sampled.json.gz文件,这个步骤是给kafka topic准备输入文件

cd $DRUID_HOME/quickstart/tutorial

gunzip -k wikiticker-2015-09-12-sampled.json.gz这个步骤操作完成后,在$DRUID_HOME/quickstart/tutorial文件夹下生成wikiticker-2015-09-12-sampled.json

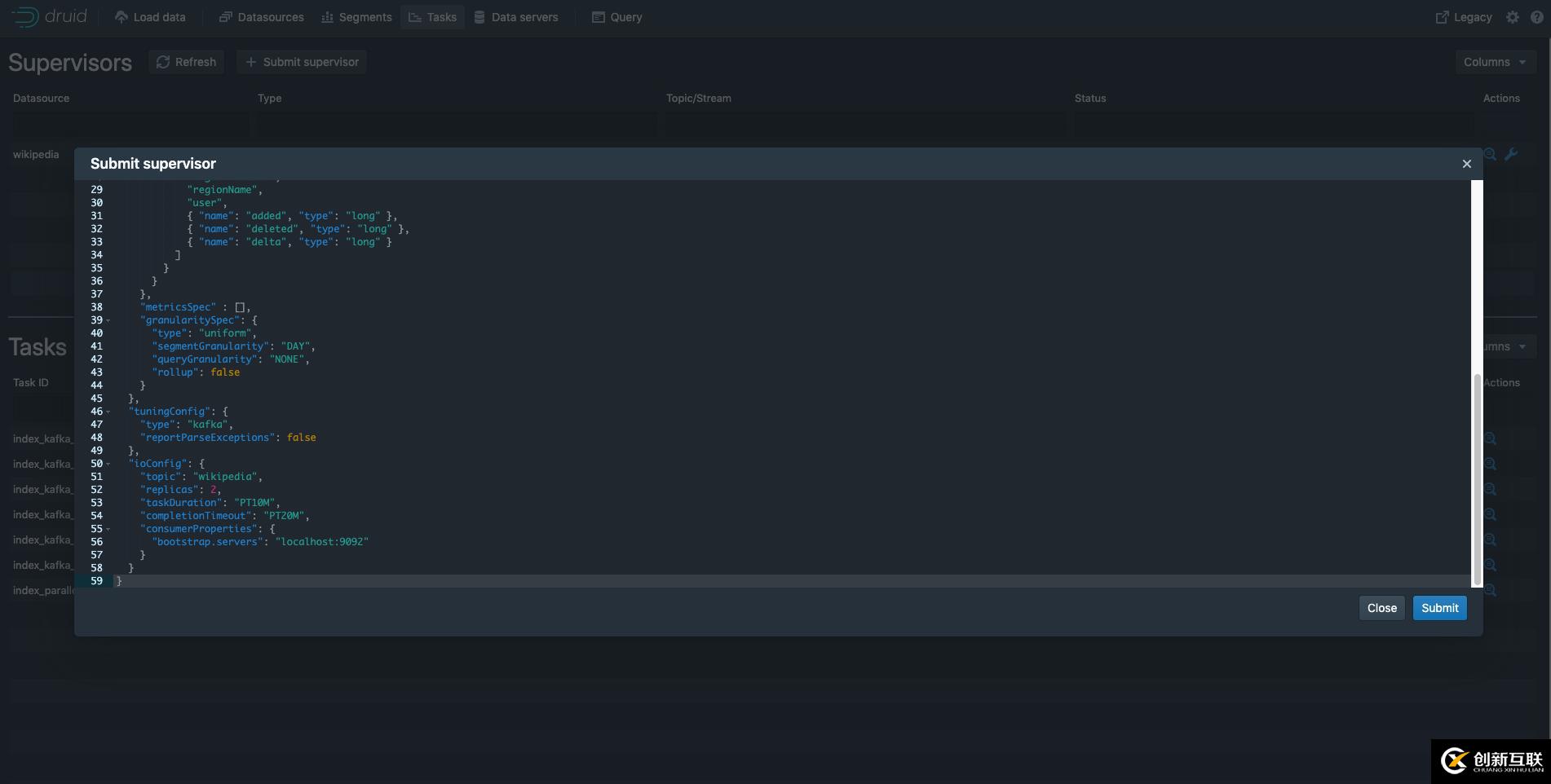

上图配置文件如下,其中bootstrap.servers配置kafka地址

{

"type": "kafka",

"dataSchema": {

"dataSource": "wikipedia",

"parser": {

"type": "string",

"parseSpec": {

"format": "json",

"timestampSpec": {

"column": "time",

"format": "auto"

},

"dimensionsSpec": {

"dimensions": [

"channel",

"cityName",

"comment",

"countryIsoCode",

"countryName",

"isAnonymous",

"isMinor",

"isNew",

"isRobot",

"isUnpatrolled",

"metroCode",

"namespace",

"page",

"regionIsoCode",

"regionName",

"user",

{ "name": "added", "type": "long" },

{ "name": "deleted", "type": "long" },

{ "name": "delta", "type": "long" }

]

}

}

},

"metricsSpec" : [],

"granularitySpec": {

"type": "uniform",

"segmentGranularity": "DAY",

"queryGranularity": "NONE",

"rollup": false

}

},

"tuningConfig": {

"type": "kafka",

"reportParseExceptions": false

},

"ioConfig": {

"topic": "wikipedia",

"replicas": 2,

"taskDuration": "PT10M",

"completionTimeout": "PT20M",

"consumerProperties": {

"bootstrap.servers": "localhost:9092"

}

}

}接下来要将wikiticker-2015-09-12-sampled.json文件内容,利用kafka生产者脚本写入wikipedia的topic中

export KAFKA_OPTS="-Dfile.encoding=UTF-8"

./bin/kafka-console-producer.sh --broker-list localhost:9092 --topic wikipedia < {PATH_TO_DRUID}/quickstart/tutorial/wikiticker-2015-09-12-sampled.json另外有需要云服务器可以了解下创新互联scvps.cn,海内外云服务器15元起步,三天无理由+7*72小时售后在线,公司持有idc许可证,提供“云服务器、裸金属服务器、高防服务器、香港服务器、美国服务器、虚拟主机、免备案服务器”等云主机租用服务以及企业上云的综合解决方案,具有“安全稳定、简单易用、服务可用性高、性价比高”等特点与优势,专为企业上云打造定制,能够满足用户丰富、多元化的应用场景需求。

网页题目:【Druid】Druid读取Kafka数据的简单配置过程-创新互联

转载注明:https://www.cdcxhl.com/article12/geggc.html

成都网站建设公司_创新互联,为您提供服务器托管、网站建设、静态网站、关键词优化、微信公众号、云服务器

声明:本网站发布的内容(图片、视频和文字)以用户投稿、用户转载内容为主,如果涉及侵权请尽快告知,我们将会在第一时间删除。文章观点不代表本网站立场,如需处理请联系客服。电话:028-86922220;邮箱:631063699@qq.com。内容未经允许不得转载,或转载时需注明来源: 创新互联

- 日本云服务器有什么特性?好不好? 2022-10-02

- 电商网站选择云服务器要考虑哪些方面 2022-10-02

- 新购云服务器需要打开常用端口 2022-12-29

- 金山云新一代GPU云服务器上线基于TeslaT4性能提升350% 2022-10-02

- 企业如何选择裸机服务器和云服务器 2022-10-14

- 云服务器好用吗?云服务器值得买吗? 2022-10-05

- 阿里云服务器Linux主机如何搭建网站环境 2023-03-17

- 怎样选购云服务器 2021-01-31

- 服务器托管和云服务器租用该如何抉择 2022-08-29

- 云服务器和虚拟主机谁更适合自主建站 2021-01-31

- 云服务器维护复杂吗?要做哪些事情? 2022-10-12

- 为何云服务器如此受欢迎? 2021-03-05